攻击目标之前,最重要的是收集信息,搜索引擎就可以自动爬取网站的内容,不过搜索引擎都要遵守robots协议(这个…至于360搜索…),robots.txt是网站管理创建的一个txt文件,告诉搜索引擎哪些文件需要被爬取、哪些文件不希望被爬取。搜索引擎的spider的大致工作过程为首先请求一个页面,然后分析这个页面,查找该页面连接到其他内容的链接,然后再请求,如此循环。

我们可以使用工具来自动抓取web站点的内容,工作原理与spider技术大致相同,但是这些工具可不受robots的约束,它们还会根据robots中禁止的目录来进行爬取。spider工具可以爬取网站的文件和目录,也可以分析HTML表单,并且可以按照指定的规则,提交表单。

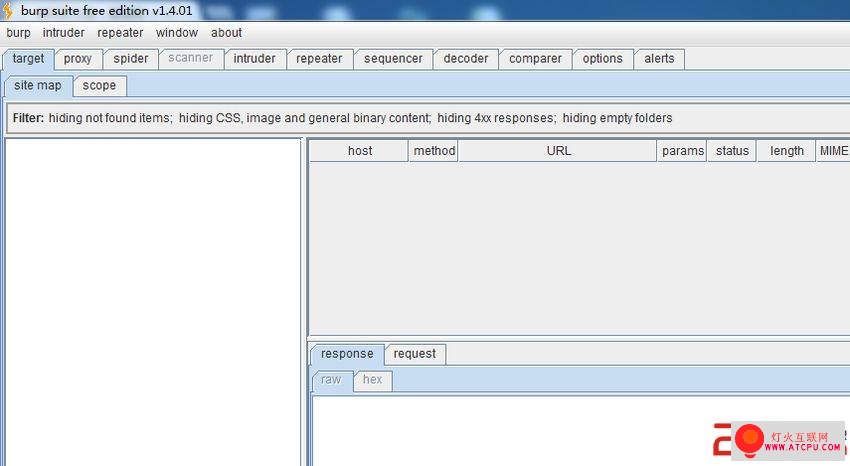

burp suite就是这样一款工具。界面如图:

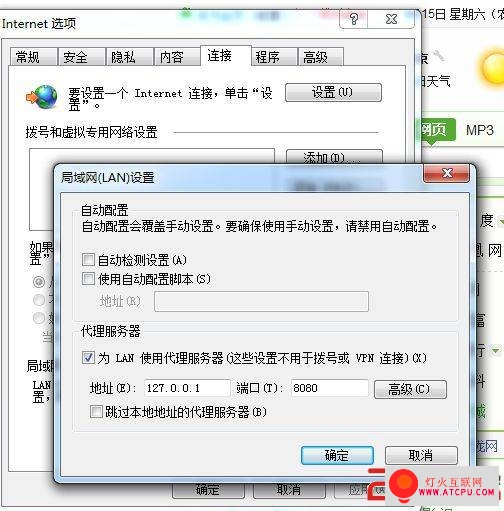

运行burp suite需要本地安装jdk,且配置了环境变量,点击运行里边的suite.bat即可,如果不成功,编辑该文件,文本内容替换成java -jar burpsuite_v1.4.01.jar即可(根据自己的版本,自行改变)。burp suite还可以拦截本地浏览器的请求,修改拦截到的数据包,人为修改后在提交给Web服务器,前提是浏览器配置了本地的代理服务器IP为127.0.0.1,端口默认 8080,如截图:

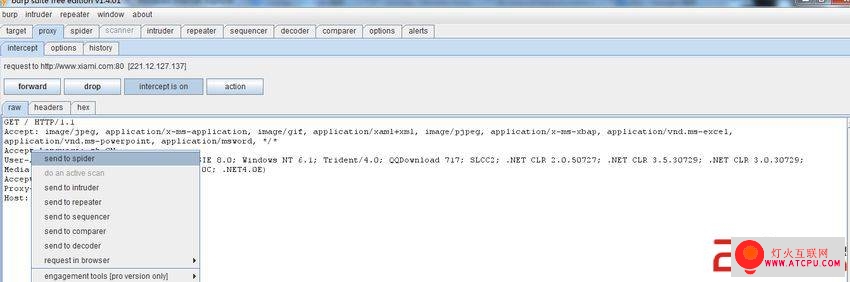

点击forward放行,点击drop丢掉改包。这样在本地浏览器中发出的包,都要经过burp suite,如截图:

可以进行相应修改后,再放行,把包发出去。

右击burp suite拦截到的包,点击发送到spider,burp suite就可以自动爬取网站的目录,如截图:

,过一段时间就可以探测出Web服务器的本地目录(由于spider是基于链接url地爬取,如果有的文件没有被链接,那spider就很难抓取到)。抓取结果如截图:

(文章只是个人学习笔记,发表出来并不赞成用各种工具和技术探测别人的服务器)。